La transmisión en vivo de 17 minutos del pistolero se vio menos de 200 veces y el primer informe de usuario no llegó hasta 12 minutos después de que terminó.

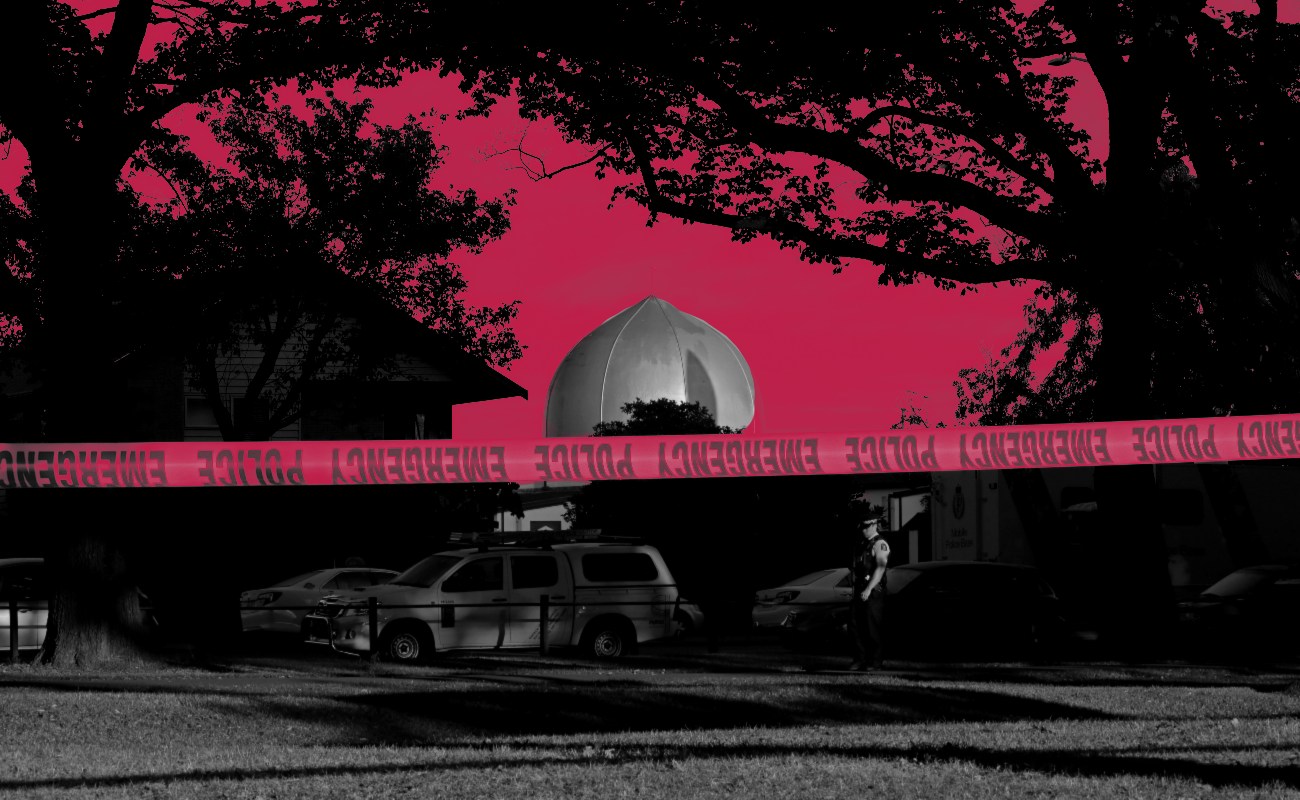

LONDRES.- Facebook dice que ninguna de las aproximadamente 200 personas que vieron videos en vivo de los disparos en la mezquita de Nueva Zelanda lo identificó ante los moderadores, lo que subraya el desafío que enfrentan las empresas de tecnología para controlar el contenido violento o perturbador en tiempo real.

El gigante de los medios sociales publicó nuevos detalles sobre su respuesta al video en una publicación de blog. Dijo que la transmisión en vivo de 17 minutos del pistolero se vio menos de 200 veces y el primer informe de usuario no llegó hasta 12 minutos después de que terminó. Cincuenta personas fueron asesinadas en dos mezquitas en Christchurch.

Facebook eliminó el video "en cuestión de minutos" de haber sido notificado por la policía, dijo Chris Sonderby, el abogado general adjunto de Facebook.

"Ningún usuario informó el video durante la transmisión en vivo", y fue visto unas 4,000 veces en total antes de ser retirado, dijo Sonderby. "Seguimos trabajando todo el día para evitar que este contenido aparezca en nuestro sitio, utilizando una combinación de tecnología y personas".

Facebook ha dicho previamente que en las primeras 24 horas después de la masacre, eliminó 1.5 millones de videos de los ataques, "de los cuales más de 1.2 millones se bloquearon en la carga", lo que implica que 300,000 copias lograron ingresar al sitio antes de ser retiradas.

La rápida difusión en línea del video pone una presión renovada en Facebook y otros sitios de medios sociales como YouTube y Twitter sobre sus esfuerzos de moderación de contenido. Muchos se preguntan por qué Facebook en particular no pudo detectar más rápidamente el video y eliminarlo.

El martes, la primera ministra de Nueva Zelanda, Jacinda Ardern, expresó su frustración por el hecho de que las imágenes permanecieran en línea cuatro días después de los asesinatos. Ella dijo que había recibido "alguna comunicación" de Sheryl Sandberg, Directora de Operaciones de Facebook, sobre el tema. "Es horrible y, si bien nos han dado esas garantías, en última instancia, la responsabilidad está en ellos".

Facebook utiliza la inteligencia artificial y el aprendizaje automático para detectar material objetable, mientras que al mismo tiempo confía en el público para identificar contenido que viola sus estándares. Luego, esos informes se envían a revisores humanos que deciden qué medidas tomar, dijo la compañía en un video en noviembre , que también describía cómo usa la "visión computarizada" para detectar el 97 por ciento de la violencia gráfica antes de que alguien lo reporte. Sin embargo, es menos claro cómo estos sistemas se aplican a la transmisión en vivo de Facebook.

Para informar un video en vivo, un usuario debe saber hacer clic en un pequeño conjunto de tres puntos grises en el lado derecho de la publicación. Cuando hace clic en "reportar video en vivo", se le ofrece una selección de tipos de contenido objetables para seleccionar, que incluyen violencia, acoso y hostigamiento. También se le indica que se comunique con la policía en su área si alguien está en peligro inmediato.

Antes de que la compañía recibiera una alerta sobre el video, un usuario de 8chan ya había publicado un enlace para copiarlo en un sitio de intercambio de archivos, dijo Sonderby.

8chan es un rincón oscuro de la web donde los que no se ven afectados por los sitios de redes sociales tradicionales suelen publicar opiniones extremistas, racistas y violentas.

En otra indicación de la difusión del video por parte de quienes intentan compartirlo, el Foro Global de Internet para Contrarrestar el Terrorismo, un grupo de compañías globales de Internet lideradas por Facebook, YouTube, Microsoft y Twitter, dijo que agregó más de 800 versiones diferentes a una base de datos compartida. Solía bloquear imágenes y videos de terroristas violentos.

El grupo dijo que agregó "huellas digitales" para las versiones visualmente distintas del video a su base de datos. El movimiento se produjo en respuesta a los intentos de los usuarios de Internet de compartir el video mediante la edición o reenvasado de versiones con diferentes huellas digitales para evitar la detección.

"El incidente destaca la importancia de la cooperación de la industria con respecto a la gama de terroristas y extremistas violentos que operan en línea", dijo el grupo, que se formó en 2017 en respuesta a la presión oficial para hacer más para combatir el extremismo en línea.

En una serie de tweets al día después de los tiroteos , el ex jefe de seguridad de Facebook, Alex Stamos, planteó el desafío para las empresas de tecnología mientras corrían para mantenerse al día con las nuevas versiones del video.

"Cada vez que esto sucede, las empresas tienen que verlo y crear una nueva huella digital", dijo Stamos. "Lo que están viendo en las plataformas principales es el agua que se filtra alrededor de miles de dedos asomados en una presa", dijo.

Stamos estimó que las grandes empresas de tecnología están bloqueando la subida de más del 99% de los videos, "lo cual no es suficiente para que sea imposible de encontrar".